1.是否掌握事务的ACID原理 你知道Mysql事务的四大特性不,简单说下 温馨提示 事务的四大特性ACID原子性Atomicity:

一致性Consistency:

隔离性Isolation:

持久性Durability:

2.是否掌握数据库常见隔离级别和对应导致的问题 能否简单解释下脏读、不可重复读、幻读的意思 温馨提示 脏读: 事务中的修改即使没有提交,其他事务也能看见,事务可以读到未提交的数据称为脏读

幻读和不可重复读的区别是:前者是一个范围,后者是本身,从总的结果来看, 两者都表现为两次读取的结果不一致

常见的隔离级别由低到高有哪几种,mysql默认是哪种 事务的隔离级别越高,事务越安全,但是并发能力越差。 Read Uncommitted(未提交读,读取未提交内容) 事务中的修改即使没有提交,其他事务也能看见,事务可以读到为提交的数据称为脏读

Read Committed(提交读,读取提交内容) 一个事务开始后只能看见已经提交的事务所做的修改,在事务中执行两次同样的查询可能得到不一样的结果,也叫做不可重复读(前后多次读取,不能读到相同的数据内容),也存幻读问题

例子:

老王事务A事先读取了数据,他女友事务B紧接了更新了数据且提交了事务,事务A再次读取该数据时,数据已经发生了改变

Repeatable Read(可重复读,mysql默认的事务隔离级别) 解决脏读、不可重复读的问题,存在幻读的问题,使用 MMVC机制 实现可重复读

例子

Serializable(可串行化) 解决脏读、不可重复读、幻读,可保证事务安全,但强制所有事务串行执行,所以并发效率低

3.是否知道Mysql的存储引擎 说下你知道Mysql常见的存储引擎,新版Mysql默认是哪个 温馨提示 常见的有多类,InnoDB、MyISAM、MEMORY、MERGE、ARCHIVE、CSV等

4.是否了解Mysql的存储引擎InnoDB&MyISAM区别和选择问题 mysql的存储引擎 innodb和myisam有什么区别,应该怎么选择 区别项 Innodb myisam 事务 支持 不支持 锁粒度 行锁,适合高并发 表锁,不适合高并发 是否默认 默认 非默认 支持外键 支持外键 不支持 适合场景 读写均衡,写大于读场景,需要事务 读多写少场景,不需要事务 全文索引 不支持,可以通过插件实现, 更多使用ElasticSearch 支持全文索引

5.考查mysql的功能索引掌握情况 mysql常用的功能索引有哪些 索引名称 特点 创建语句 普通索引 最基本的索引,仅加速查询 CREATE INDEX idx_name ON table_name(filed_name) 唯一索引 加速查询,列值唯一,允许为空; CREATE UNIQUE INDEX idx_name ON table_name(filed_name_1,filed_name_2) 主键索引 加速查询,列值唯一, ALTER TABLE table_name ADD PRIMARY KEY ( filed_name ) 组合索引 加速查询,多条件组合查询 CREATE INDEX idx_name ON table_name(filed_name_1,filed_name_2); 覆盖索引 索引包含所需要的值,不需要“回表”查询, 全文索引 对内容进行分词搜索,仅可用于Myisam, 更多用ElasticSearch做搜索 ALTER TABLE table_name ADD FULLTEXT ( filed_name )

6.考查索引的使用场景和注意事项 你们线上数据量每天有多少新增,都是存储在mysql库吗,有没做优化 温馨提示 中型公司或者业务发展好的公司,一天新增几百万数据量

你创建索引的时候主要考虑啥,使用索引的优缺点有哪些,使用应该注意些什么 温馨提示 考虑点:结合实际的业务场景,在哪些字段上创建索引,创建什么类型的索引 索引好处: 索引缺点: 索引优化实践

7.数据库查询关键词执行顺序 数据库查询的指令有多个,说下执行顺序 select、where、from、group by、having、order by from 从哪个表查询

where 初步过滤条件

group by 过滤后进行分组[重点]

having 对分组后的数据进行二次过滤[重点]

select 查看哪些结果字段

order by 按照怎样的顺序进行排序返回[重点]

select video_id,count(id) num from chapter group by video_id having num >10

order by video_id desc 8.设计数据库的时候相似类型的字段区分 varchar(len) char(len) len存储的是字符还是字节 对比项 char(16) varchar(16) 长度特点 长度固定,存储字符 长度可变,存储字符 长度不足情况 插入的长度小于定义长度时,则用空格填充 小于定义长度时,按实际插入长度存储 性能 存取速度比varchar快得多 存取速度比char慢得多 使用场景 适合存储很短的,固定长度的字符串,如手机号,MD5值等 适合用在长度不固定场景,如收货地址,邮箱地址等

9.是否知道常用的数据库时间类型相似字段的区别 MySQL中的datetime和timestamp有什么区别 类型 占据字节 范围 时区问题 datetime 8 字节 1000-01-01 00:00:00到 9999-12-31 23:59:59 存储与时区无关,不会发生改变 timestamp 4 字节 1970-01-01 00:00:01 到 2038-01-19 11:14:07 存储的是与时区有关,随数据库的时区而发生改变

为什么timestamp只能到2038年 温馨提示 MySQL的timestamp类型是4个字节,最大值是2的31次方减1,结果是2147483647,

10.针对大数据量sql分页优化思路 线上数据库的一个商品表数据量过千万,做深度分页的时候性能很慢,有什么优化思路 现象:千万级别数据很正常,比如数据流水、日志记录等,数据库正常的深度分页会很慢

慢的原因:select * from product limit N,M

MySQL执行此类SQL时需要先扫描到N行,然后再去取M行,N越大,MySQL扫描的记录数越多,SQL的性能就会越差

1、后端、前端缓存

2、使用ElasticSearch分页搜索

3、合理使用 mysql 查询缓存,覆盖索引进行查询分页

select title,cateory from product limit 1000000,100

4、如果id是自增且不存在中间删除数据,使用子查询优化,定位偏移位置的 id

select * from oper_log where type='BUY' limit 1000000,100; //5.秒

select id from oper_log where type='BUY' limit 1000000,1; // 0.4秒

select * from oper_log where type='BUY' and id>=(select id from oper_log where type='BUY' limit 1000000,1) limit 100; //0.8秒

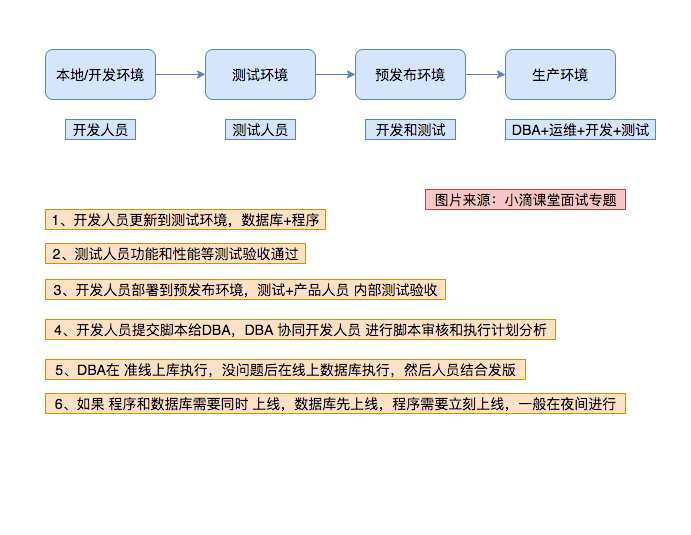

11.是否有正确的数据库部署流程 你公司里面产品迭代更新,开发好代码和数据库,上线流程是怎样的

12.是否有监控和数据安全思维 针对线上的数据库,你会做哪些监控,业务性能 + 数据安全 角度分析 温馨提示 大厂一般都有数据库监控后台,里面指标很多,但是开发人员也必须知道业务性能

4、吞吐量QPS/TPS,一天内读写随着时间的变化统计图数据安全

5、数据库账号密码 业务独立,权限独立控制,防止多库共用同个账号密码

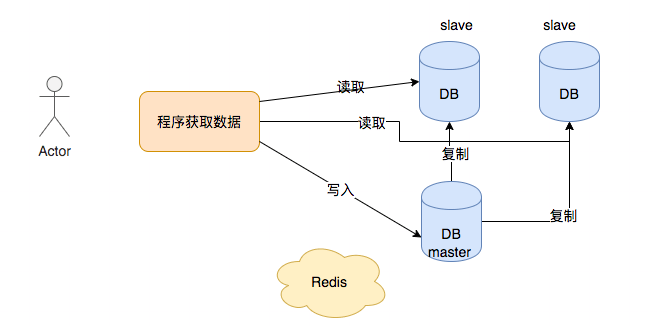

6、高可用 主从架构,多机房部署

13.mysql常见日志种类和作用 Mysql有多少种常见的日志,分别解释日志的作用 温馨提示 redo 重做日志

undo 回滚日志

errorlog 错误日志

slow query log 慢查询日志 binlog 二进制日志

relay log 中继日志

general log 普通日志

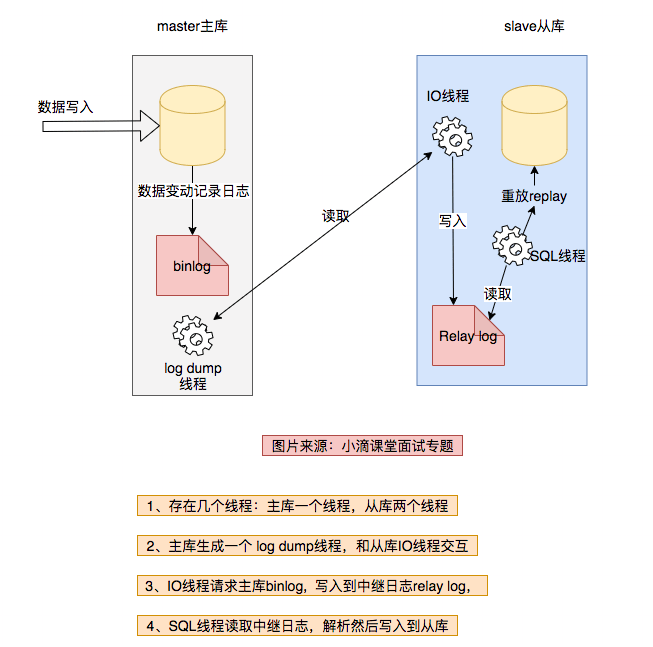

14.是否搭建过主从,并掌握原理 你们数据库是单点的吗?有没做多节点优化 ,怎么做的 温馨提示 我们公司数据库不是单节点,是多节点的,有做主从复制

既然搭建过数据库主从复制,你能画下流程图说下异步复制原理不

15.数据库主从遇到的问题和解决办法 你们搭建数据库主从复制的目的有哪些 温馨提示 容灾使用,用于故障切换

既然你们搭建了主从同步,且你们日增量数据量也不少,有没遇到同步延迟问题 温馨提示 保证性能第一情况下,不能百分百解决主从同步延迟问题,只能增加缓解措施。

3、服务器硬件问题,如磁盘,CPU,还有网络延迟等

解决办法:

4、提高硬件配置,比如使用SSD固态硬盘、更好的CPU和网络

5、进行分库分表,减少单机压力

16.搭建主从复制,有没做过数据一致性校验 什么场景下会出现主从数据不一致 温馨提示 1、本身复制延迟导致

是否有做过主从一致性校验,你是怎么做的,如果没做过,你计划怎么做 温馨提示 Mysql主从复制是基于binlog复制,难免出现复制数据不一致的风险,引起用户数据访问前后不一致的风险

解决方案之一,使用Percona公司下的工具

pt-table-checksum工具进行一致性校验

原理:

pt-table-sync(在从库执行)工具进行修复不一致数据,可以修复主从结构数据的不一致,也可以修复非主从结构数据表的数据不一致

原理:在主库上执行数据的更改,再同步到从库上,不会直接更改成从的数据。在主库上执行更改是基于主库现在的数据,也不会更改主库上的数据,可以同步某些表或整个库的数据,但它不同步表结构、索引,只同步不一致的数据

注意:

pt-table-checksum怎么保证某个chunk的时候checksum数据一致性? 温馨提示 当pt工具在计算主库上某chunk的checksum时,主库可能在更新且从库可能复制延迟,那该怎么保证主库与从库计算的是”同一份”数据,答案把要checksum的行加上for update锁并计算,这保证了主库的某个chunk内部数据的一致性

官方地址:https://www.percona.com/downloads/percona-toolkit/LATEST/

其他资料:https://www.cnblogs.com/zishengY/p/6852280.html